Einleitung: Mehr als nur „Slop“ – Die missverstandene Botschaft über die Zukunft der KI

Kürzlich sorgte der Auftritt von KI-Legende Andrej Karpathy in einem bekannten Podcast im Silicon Valley für Aufsehen. Schlagzeilen behaupteten, er hätte KI-Agenten als „Slop“ (Schrott) bezeichnet und damit den Hype beendet. Wer den Podcast jedoch aufmerksam verfolgte, erkannte schnell eine massive Fehlinterpretation.

Karpathys eigentliche Aussage war weitaus nuancierter: Vollständig autonome, selbstlernende Agenten (Tier 3), die ohne Leitplanken agieren, sind wahrscheinlich noch ein Jahrzehnt entfernt. Das bedeutet jedoch keineswegs, dass die heutigen Agenten nutzlos sind. Diese Verkürzung ist frustrierend, denn sie ignoriert die enormen Fortschritte und den realen Nutzen, den praxistaugliche Agenten schon heute liefern.

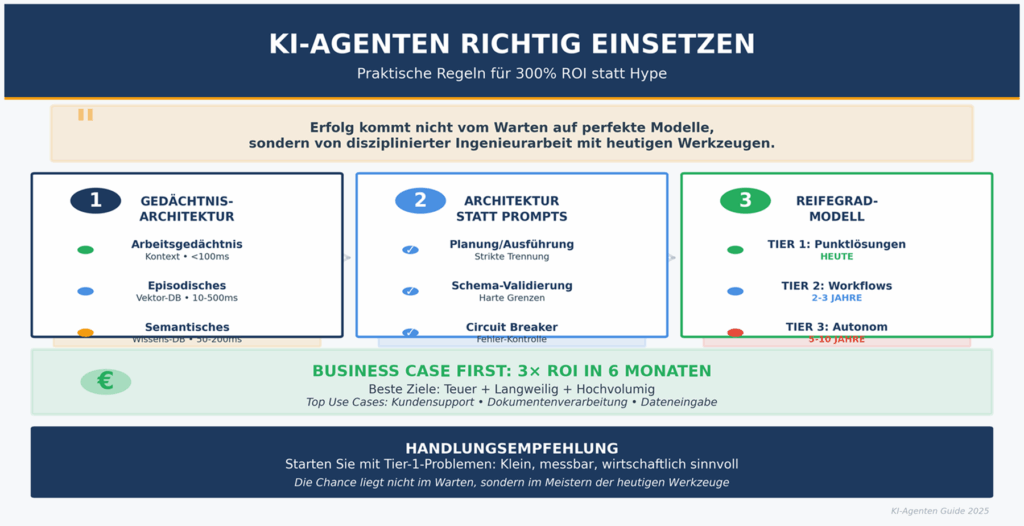

Dieser Artikel lässt die oberflächliche Debatte hinter sich und konzentriert sich auf die wirklich wichtigen, oft überraschenden Prinzipien, um mit der heutigen Technologie nützliche und wertschöpfende KI-Agenten zu entwickeln. Es geht nicht darum, auf die perfekte Technologie zu warten, sondern darum, mit den Werkzeugen, die wir haben, diszipliniert zu arbeiten.

Die Architektur des Gedächtnisses ist wichtiger als das KI-Modell

Karpathy identifizierte das Gedächtnis als das zentrale Architekturproblem für Agenten – und er hat absolut recht. Ich habe dies auf die harte Tour gelernt: Die Architektur des Gedächtnisses bestimmt die Fähigkeiten eines Agenten weitaus stärker als die Wahl des Modells. Ein Agent ohne ein durchdachtes Gedächtnissystem kann nicht aus Erfahrungen lernen, sich nicht verbessern und keine komplexen Aufgaben bewältigen.

Es gibt drei grundlegende Arten von Gedächtnis, die jeweils unterschiedliche architektonische Lösungen erfordern:

- Arbeitsgedächtnis (Working Memory): Dies ist das Kurzzeitgedächtnis, das im Kontextfenster des Modells lebt (typischerweise 2.000 bis 200.000 Tokens). Es ist für den aktuellen Task zuständig, hat eine sehr geringe Latenz (unter 100 Millisekunden) und ist absichtlich flüchtig – es wird nach Abschluss der Sitzung gelöscht.

- Episodisches Gedächtnis (Episodic Memory): Dieses Gedächtnis speichert Erfahrungen über Sitzungen hinweg, typischerweise in einer Vektordatenbank. Es ermöglicht dem Agenten, aus vergangenen Fehlern und Erfolgen zu lernen. Die Latenz liegt zwischen 10 und 500 Millisekunden, und es wird nach signifikanten Ereignissen aktualisiert, nicht bei jeder Interaktion.

- Semantisches Gedächtnis (Semantic Memory): Hier wird Domänenwissen gespeichert, das sich nur langsam ändert (z. B. Produktkataloge oder Unternehmensrichtlinien), oft in Wissensdatenbanken oder strukturierten Datenspeichern. Die Latenz beträgt 50 bis 200 Millisekunden, und Updates erfolgen zyklisch (wöchentlich, monatlich oder quartalsweise).

Die Bedeutung dieses Punktes kann nicht genug betont werden. Wie es im Quelltext heißt:

Memory architecture determines agent capabilities more than model selection does.

Der Fokus auf die Speicherarchitektur ist kontraintuitiv, weil die öffentliche Diskussion von neuen, leistungsfähigeren Modellen dominiert wird. In der Praxis jedoch schaltet eine robuste Gedächtnisarchitektur das Potenzial selbst älterer Modelle frei, während eine schlechte Architektur die Fähigkeiten des besten Modells begrenzt.

Zuverlässigkeit entsteht durch Architektur, nicht durch Prompts

Der Versuch, einem LLM Zuverlässigkeit per Prompt beizubringen, ist ein weit verbreiteter Fehler. Entwickler schreiben immer komplexere System-Prompts und hoffen, dem Modell per Anweisung beizubringen, keine Fehler zu machen. Dies ist ein aussichtsloses Unterfangen, denn nicht-deterministische Komponenten erfordern deterministische Container.

Die Lösung liegt nicht im „Prompt-Flüstern“, sondern in der Systemarchitektur. Man muss deterministische Leitplanken um den von Natur aus unzuverlässigen Agenten bauen. Die Metapher, die diesen Ansatz am besten verdeutlicht: Wir schaffen „enge Gänge mit verschlossenen Türen“ anstelle von „offenen Plätzen“, auf denen der Agent unkontrolliert umherwandern kann.

Konkrete architektonische Muster zur Erhöhung der Zuverlässigkeit umfassen:

- Trennung von Planung und Ausführung: Ein Agent kann frei Informationen sammeln (Datenbanken abfragen, Dokumente analysieren – reine Lese-Operationen). Bevor er jedoch einen Zustand ändert (eine E-Mail sendet, einen Datenbankeintrag modifiziert – eine Schreib-Operation), muss diese Aktion eine explizite, validierende Architekturgrenze überwinden.

- Harte Iterationsgrenzen und Schema-Validierung: Statt in Prompts um Zuverlässigkeit zu bitten, erzwingt man sie im Code. Harte Iterationsgrenzen beenden Endlosschleifen, bevor sie das Budget sprengen. Die strikte Validierung von Ausgabeformaten (z. B. JSON-Schema) stellt sicher, dass der Agent nur strukturierte, korrekte Daten an andere Systeme weitergibt.

- Circuit Breaker (Sicherungsschalter): Dieses Muster verhindert, dass ein fehlerhafter Agent in einer Schleife externe Systeme überlastet. Nach einer definierten Anzahl von Fehlversuchen unterbricht der „Sicherungsschalter“ den Prozess und eskaliert das Problem an einen Menschen oder ein Fallback-System.

Dieser architektonische Ansatz erfordert eine grundlegende Umstellung des Denkens: weg von der Rolle des „Prompt-Flüsterers“, der versucht, ein Modell zu überreden, hin zur Rolle des Systemarchitekten, der ein robustes und fehlertolerantes System entwirft.

Ihr Agent ist ein Business Case, kein Forschungsprojekt

Die technisch brillanteste Implementierung ist wertlos, wenn die Wirtschaftlichkeit nicht stimmt. Bevor eine einzige Zeile Code geschrieben wird, muss die Wirtschaftlichkeit eines Agenten modelliert werden. Wie hoch sind die Token-Kosten pro erfolgreichem Ergebnis? Wie schneidet dieser Wert im Vergleich zu den vollständig kalkulierten Kosten des manuellen Prozesses ab – also inklusive Gehalt, Sozialleistungen, Management-Overhead und Fehlerkosten?

Die besten Anwendungsfälle für KI-Agenten finden sich bei Problemen, die gleichzeitig teuer, langweilig und hochvolumig sind. Suchen Sie nach „Kostenkonzentration“: Szenarien, in denen kleine Effizienzgewinne zu großen Kosteneinsparungen führen, etwa wenn die Automatisierung von 20 % der Supportanfragen die Einstellung von zwei neuen Mitarbeitern überflüssig macht. Beispiele hierfür sind:

- Triage im Kundensupport

- Verarbeitung von Rechnungen, Verträgen und anderen Dokumenten

- Dateneingabe und -validierung

Eine klare Faustregel lautet: Wenn der Agent nicht innerhalb von sechs Monaten einen 3-fachen ROI liefert, sollte man entweder warten, bis die Technologie günstiger wird, oder ein anderes Problem suchen. Die erfolgreichsten KI-Projekte sind selten die technologisch aufregendsten, sondern die wirtschaftlich sinnvollsten.

Beginnen Sie bei „Tier 1“ – Die langweiligen Probleme sind die besten

Der größte Fehler beim Bau von Agenten ist, zu komplex zu beginnen. Es ist entscheidend zu verstehen, welche Fähigkeiten heute realistisch umsetzbar sind. Hier hilft ein Drei-Stufen-Modell:

- Tier 1 (Punktlösungen): Heute machbar. Dies sind Agenten für einzelne, eng definierte Aufgaben wie die Extraktion von Daten aus einem Dokument. Ihr Umfang ist begrenzt, ihr Erfolg klar messbar und ihr Wert sofort realisierbar.

- Tier 2 (Workflow-Agenten): In 2–3 Jahren aufkommend. Diese Agenten koordinieren mehrstufige Prozesse über verschiedene Systeme hinweg, z. B. die vollständige Bearbeitung eines Versicherungsanspruchs.

- Tier 3 (Autonome Agenten): In 5–10 Jahren realistisch. Dies sind die selbstständig agierenden Agenten mit minimaler menschlicher Aufsicht, über die Karpathy sprach.

Der größte unmittelbare und messbare Wert liegt heute in Tier-1-Anwendungen. Zu versuchen, direkt einen Tier-2- oder Tier-3-Agenten zu bauen, führt fast immer zu überkomplexen, unzuverlässigen und unwirtschaftlichen Projekten.

Das Meistern von Tier-1-Problemen bringt nicht nur einen enormen ROI, sondern schafft auch die notwendige Erfahrung und die architektonischen Grundlagen für die komplexeren Agenten von morgen. Die meisten Entwickler überschätzen, wie Tier 3 aussehen wird, und unterschätzen den Wert, der heute in Tier 1 verfügbar ist.

Zum Schluss: Bauen Sie mit dem, was Sie haben, nicht mit dem, was Sie sich wünschen

Das Jahrzehnt der Agenten beginnt nicht mit perfekter Technologie, sondern mit disziplinierten Entwicklern, die verstehen, wie man aus unvollkommenen Werkzeugen einen echten Mehrwert extrahiert. Der Erfolg kommt nicht vom Warten auf perfekte Modelle, sondern von disziplinierter Ingenieurarbeit mit den Werkzeugen von heute. Es geht um robuste Architektur, klare Wirtschaftlichkeit und einen unerbittlichen Fokus auf lösbare Probleme.

Die Chance liegt nicht im Warten, sondern im Meistern. Die Teams, die jetzt lernen, wertvolle Tier-1-Agenten zu bauen, werden diejenigen sein, die die komplexeren Systeme der Zukunft anführen.

Welches teure, langweilige und hochvolumige Problem in Ihrem Unternehmen wartet darauf, von einem intelligent konzipierten KI-Agenten gelöst zu werden?

© 2025 Dieser Beitrag beruht auf eigenständiger Recherche und Analyse diverser Quellen;

eine KI leistete lediglich sprachliche Unterstützung, die inhaltliche Verantwortung trägt ausschließlich der Autor.

Schreibe den ersten Kommentar